号外:生成型AIへの規制とリスク管理

Chat GPTのような生成型AIが登場し、その取扱いに世界中が右往左往しているように思えます。生成型AIはIT技術の進歩によって登場しました。人間がひとりで情報収集できる範囲や、それを記憶できる量には、自ずと限界があります。しかしコンピューターおよびそのネットワークは、それこそ世界中の膨大な量の情報(個々に真偽が定かでないものも含めて)にアクセスし、記憶し(人間のように忘れることはありません)、それをアルゴリズム(人間が与えた基本的な方法やルール)に従って組み合わせ、断片的な情報からストーリーをつくり上げることができます。しかしその情報の組み合わせは、既存の情報の内容や性質、人間の指示から類推される「ありがちな傾向」に基づいたもので、全体としての真偽が確認されたものである保証はありません。AIは個々の情報をデータとして扱っているだけで、それぞれの情報が(論理的、倫理的に)正しいかどうか、(科学的、歴史的に)正確かどうかの判断をしているわけではありません。なんとも厄介なものが登場したものだと思います。うまく使えれば、これまで人間が手間と時間をかけてこなしていた作業の負荷を低減し、新たな価値を生み出すのかもしれません。その一方で、使い方を間違えると(安易に頼ったり、過信したりすると)、根拠が不確かな情報に振り回されることになるのかもしれません。個人的に気になることがあります。人間にとって、自分で集めた情報を整理し、自力で自分の思考を組み立てること(言語化し、文章化すること)はとても重要です。その結果がたとえ不十分なものだったとしても、そのような自力作業(苦労)の結果として得たものだけが、自分の中に知恵や経験として蓄積され、定着するのだと思います。その大変な部分をAI(機械やシステム)が肩代わりしてくれることが、必ずしも効率的で、まして生産性の向上に直結するとは思えません。不必要に膨大な情報の海の上を、AIというサーフボードに乗って滑っていて、一過性の回答を得ることで満足してしまい、物事の本質にはなかなか迫れないのではないかと危惧してしまいます。私は古いタイプの人間のようです。しかし私自身は、これまでのようにボチボチと情報収集し、何とか自力で考えて、少しずつ歩いていきたいと思っています。

2023年6月30日付け日本経済新聞電子版に掲載された記事より、

“生成人口知能(AI)の急速な普及が企業活動や社会を大きく変えようとしている。社会への影響が甚大な新技術が登場するたびにその利用をどう適正にコントロールするか、これまでにも試行錯誤があった。AI規制は過去にない難しさがある。”

“遺伝子組み換えが可能になった直後の1975年、米カリフォルニア州アシロマに世界から科学者が集まって研究を自主規制するガイドラインを決めた。組み換えで未知の細菌を作り出すリスクが指摘されたからだ。2005年ごろ台頭したゲノム編集では、後に生殖細胞への適用を禁ずる指針が生まれた。ゲノム編集で改造した遺伝情報が子孫に広がったら人類そのものの改変につながる恐れがあると指摘された。”

“新技術は一部の専門家にとっては長年の追求目標だろうが、一般の人には「注文しないのに届いたカツ丼」のようなものだ。おなかいっぱいなのに食べねばならず代金も求められる。「誰が作ってくれと頼んだのだ」と問い掛けたくなる。「Chat GPTにだまされ続けた。恥ずかしい」。米ニューヨーク・タイムズ紙(6月8日付)によると、ニューヨークの米連邦地方裁判所で弁護士が居並ぶ判事たちの前で自らの過ちを弁解したという。弁護士はChat GPTで判例を検索し法廷に提出したが、それはAIが創作した架空の判例だった。AIが提示するもっともらしい作り話を専門家は「幻覚(ハルネーション)」と呼ぶが、その弁護士はAIが時に嘘をつくことを知らず使い方を誤った。AIが生成した米国防省付近での爆発のフェイク画像で株式市場が混乱した事例もある。”

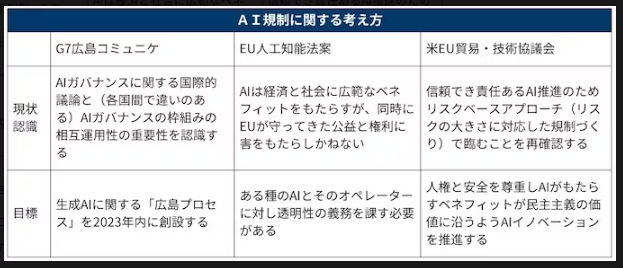

“欧州議会は6月14日、欧州連合(EU)のAI規制法案の修正案を採択した。Chat GPTのような汎用性の高いAIを「高リスクAI」と分類し、システムを公的データベースに登録することやAIで生成したコンテンツはそれとわかるように示す透明性をシステム提供者に求める内容だ。例えばAIが生成した文章は字体を変え、AIの「幻覚」をうのみにしないセーフガードとする狙いだ。”

“国内では日本新聞協会が「言論空間の混乱が進めば社会の動揺を招く」とする見解を公表している。AIにはこれまでの新技術のガバナンス(管理、運営)の枠に入りきれない要素がある。ひとつは技術進歩の速度だ。データ量やシステムを大きくすればするほど性能が上がることがはっきりしている。急増する投資と利用の拡大で性能・機能が向上、使い道が広がる。規制が容易に追いつけない。もうひとつ。遺伝子組み換えなどの新技術には開発者を戒め、研究を制約する倫理規定やガイドラインが編み出された。AIでも同様の倫理が求められる。同時にユーザーも悪用しない心得(リテラシー)が必要だ。ユーザーが故意、またはうっかりで加害者になる。その点で汎用性が高いAIの規制は自動車社会の交通ルールなどに似た一面がある。ただAIは言葉や画像を通じ人の心に働きかけ社会を動かしかねない点で提示するリスクはより広範だといえる。”

“5月の主要7ヶ国首脳会議(G7広島サミット)で先進各国がAIの国際ルールづくり(広島AIプロセス)で合意した。一方で米欧は2極間で生成AIの開発・利用と社会的リスク低減で共同歩調をとることで合意している。生成AI活用の利点を踏まえつつも、AIがもたらす多面的なリスクを大きくとらえた議論を国内でも急ぐ必要がある。”